Viver em pleno século XXI e não ouvir falar sobre como funciona a Inteligência Artificial é raro. Isso senão impossível.

Afinal, esse mundo é guiado por um estilo de vida carregado de oportunidades criadas por décadas de estudo relacionados ao uso da tecnologia.

E assim como o homo erectus descobrindo o fogo na pré-história, trabalhar na construção da Inteligência Artificial abriu novas portas para transformações além do que podemos imaginar (a não ser pela série Black Mirror, que parece prever muitas dessas coisas).

No livro “Vida 3.0: o ser humano na era da inteligência artificial” de Max Tegmark, o cosmólogo e professor do MIT nos mostra como o mundo parece mais preocupado com a combinação de três grandes equívocos distintos: consciência, o mal e robôs. Mas o que parece não ser observado é uma experiência muito mais subjetiva. Imagem: Reprodução/iStock.

É claro que, só recentemente, pudemos observar uma alta na abordagem da IA, principalmente porque surgiram ferramentas, possibilidades e oportunidades de usarmos a tecnologia em nossa rotina.

Criando músicas, textos, vídeos e arte; construindo softwares; avaliando relatórios, leis e estudos; guiando carros de forma automática e muito mais…

Vimos na prática, como a IA realmente pode ser utilizada ao nosso favor nos mais diversos aspectos da vida.

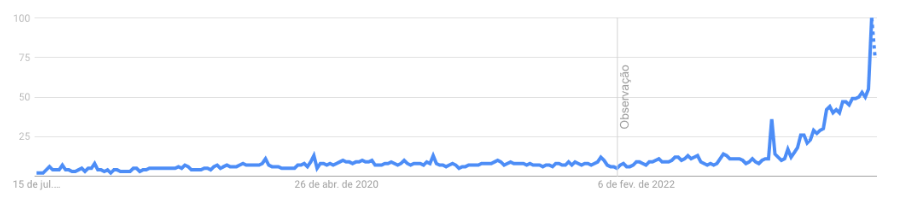

É possível ver claramente uma curva de crescimento de 2022 em diante da busca pelo termo Inteligência Artificial nos mecanismos de busca, gerando quase 100 milhões de resultados diferentes para os interessados. Reprodução: Google Trends

Mas apesar de parecer, este não é um termo novo: há mais de 60 anos estudamos, analisamos, provamos, aplicamos e construímos coisas relacionadas a eles.

No geral, observamos a IA aplicada de forma limitada, ou seja, com a capacidade de atingir um conjunto restrito de metas, como jogar xadrez ou dirigir um carro.

O termo Inteligência Artificial busca representar uma inteligência (capacidade de atingir objetivos complexos) de forma não biológica. Imagem: Reprodução/ iStock

Além disso, também temos a Inteligência Artificial Geral, que apresenta a capacidade de atingir praticamente qualquer objetivo, incluindo o aprendizado;

A IA Universal, que tem a capacidade de adquirir inteligência geral com acesso a dados e recursos e a IA Geral, que possui um nível humano com capacidade de realizar qualquer tarefa cognitiva pelo menos tão bem quanto os seres humanos.

As últimas opções, no entanto, ainda são de grande discussão entre os profissionais da área, principalmente na decisão de: “Em quanto tempo teremos uma IA Geral?”.

A média diz que pode ser até 2055, mas outros físicos apontam centenas de anos. Infelizmente não temos muito como saber.

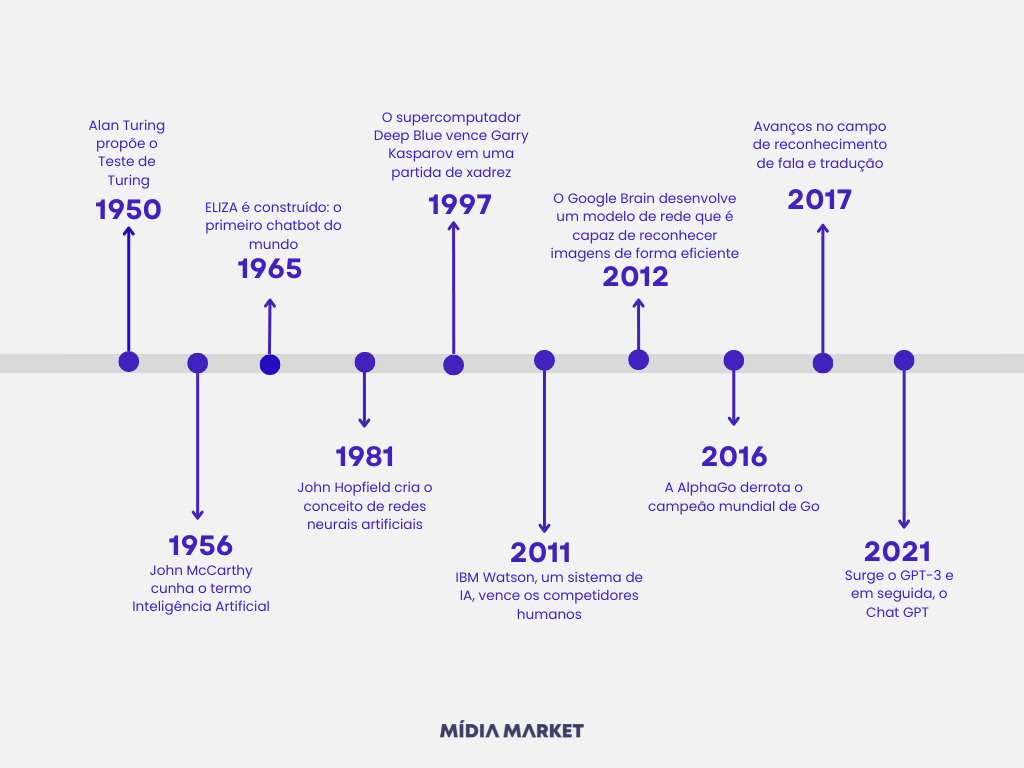

Mas antes de falar sobre o futuro, sobre IA Geral e toda a sua competência, é interessante entendermos quando esse termo começou realmente a ser utilizado. Por isso, decidimos voltar ao passado para entender um pouco essa linha do tempo:

O primeiro e maior marco relacionado a Inteligência Artificial caminhou com Alan Turing, o pai da ciência computacional, matemático, cientista da computação, lógico, criptoanalista, filósofo e biólogo teórico britânico.

Através de seu artigo “Computing Machinery and Intelligence”, em 1950, ele propôs o Teste de Turing, em que: se uma máquina pudesse enganar um juiz humano em uma conversa, simulando respostas humanas de maneira convincente, então poderíamos considerá-la “inteligente”.

O Teste de Turing continua sendo uma referência importante na avaliação e discussão sobre a capacidade de uma máquina exibir inteligência.

Embora não seja considerado um teste definitivo, ele levanta questões interessantes sobre a natureza da inteligência e os limites da capacidade das máquinas em imitar ou replicar comportamentos humanos inteligentes.

O Teste de Turing levanta questões importantes sobre inteligência artificial e consciência, e tem sido um ponto de referência na discussão sobre a natureza da mente e da inteligência. Imagem: Reprodução/ iStock

O termo “inteligência artificial” foi cunhado por John McCarthy em 1956 durante a Conferência de Dartmouth, considerada um marco no início oficial da pesquisa em IA.

McCarthy, juntamente com outros pesquisadores, propôs a ideia de que máquinas poderiam ser programadas para imitar a capacidade humana de raciocínio, aprendizado e resolução de problemas.

Nessa conferência, McCarthy fez uma apresentação intitulada “A Program for Computer Chess” (Um Programa para Xadrez Computadorizado), onde ele descreveu seu trabalho em criar um programa de computador capaz de jogar xadrez de forma autônoma.

Foi nesse contexto que ele introduziu o termo “inteligência artificial” para descrever o objetivo geral da pesquisa em criar máquinas que possam exibir comportamento inteligente.

Desde então, o termo “inteligência artificial” tem sido amplamente utilizado para descrever o campo de estudo e desenvolvimento de sistemas e algoritmos que buscam replicar ou simular a inteligência humana em máquinas. Imagem: Reprodução/ iStock

Joseph Weizenbaum, um cientista da computação, desenvolveu o programa de computador ELIZA e, hoje, este é considerado um dos primeiros programas de inteligência artificial e marcou uma das primeiras aplicações práticas da IA.

A princípio, o ELIZA foi projetado para simular uma conversa terapêutica entre um paciente e um terapeuta. Dessa forma, o programa utilizava técnicas de processamento de linguagem natural para analisar as respostas do usuário e gerar respostas adequadas, imitando o estilo de um terapeuta.

Apesar de suas capacidades limitadas, ele foi capaz de engajar os usuários em diálogos aparentemente significativos e emocionalmente envolventes.

O desenvolvimento dessa ferramenta contribuiu para a compreensão de como as máquinas podem interagir com os seres humanos através da linguagem natural e inspirou futuras pesquisas em interfaces de conversação e assistentes virtuais. Imagem: Reprodução/iStock.

ELIZA também destacou questões éticas relacionadas à simulação de interações humanas e ao impacto emocional que as máquinas podem ter nas pessoas. Este foi um marco importante no campo da inteligência artificial, demonstrando o potencial das máquinas em simular comportamentos humanos e abrir caminho para o desenvolvimento de tecnologias de interação homem-máquina baseadas em conversação.

John Hopfield introduziu o conceito de redes neurais artificiais em um artigo intitulado “Neural Networks and Physical Systems with Emergent Collective Computational Abilities”, propondo um modelo matemático de uma rede neural, conhecido como rede neural de Hopfield.

Essa rede consiste em um conjunto de unidades interconectadas, ou “neurônios”, que são capazes de armazenar e processar informações de forma paralela.

Além disso, ela é baseada em princípios inspirados no funcionamento do cérebro humano.

Assim, cada neurônio recebe entradas ponderadas, realiza um cálculo e produz uma saída. As conexões entre os neurônios possuem pesos que determinam a força e a direção da influência entre eles.

O trabalho de John Hopfield na introdução das redes neurais artificiais foi fundamental para impulsionar o campo da inteligência artificial e estabelecer bases teóricas para a aplicação prática dessas redes em problemas complexos de processamento de informações.

Essa abordagem de redes neurais artificiais abriu caminho para o desenvolvimento de modelos computacionais capazes de aprender e adaptar-se a partir de dados. Imagem: Reprodução/ Mídia Market

Deep Blue, um supercomputador altamente avançado desenvolvido pela IBM foi projetado para realizar cálculos complexos e avaliar milhões de posições de xadrez por segundo e conquistou uma vitória histórica ao derrotar o campeão mundial de xadrez, Garry Kasparov, em uma partida de seis jogos.

A vitória do Deep Blue sobre Kasparov foi um marco importante na história da inteligência artificial, pois demonstrou que uma máquina era capaz de superar um dos melhores jogadores de xadrez do mundo.

Embora a vitória tenha sido uma conquista notável, é importante notar que o programa foi especificamente projetado para jogar xadrez e não representava uma inteligência geral.

No entanto, esse evento destacou o potencial das máquinas em superar os seres humanos em tarefas específicas e impulsionou ainda mais o desenvolvimento de sistemas de IA em diferentes domínios. Imagem: Reprodução/AFP PHOTO/STAN HONDA e ADAM NADEL

A vitória do IBM Watson no Jeopardy! foi outro marco importante no avanço da inteligência artificial.

Ela demonstrou o potencial das máquinas em competir e superar os seres humanos em um domínio desafiador de conhecimento geral e linguagem natural.

Além disso, o Watson foi desenvolvido como uma plataforma que poderia ser aplicada em diversas áreas, desde assistência médica até análise de dados empresariais, contribuindo para o impulso contínuo da IA em vários setores.

O IBM Watson foi desenvolvido como parte de um projeto de pesquisa e aplicação de tecnologia de IA pela IBM e utilizava técnicas avançadas de processamento de linguagem natural, busca de informações e aprendizado de máquina para entender e responder a perguntas complexas em tempo real.

O desafio no programa Jeopardy! foi significativo, pois as perguntas do jogo são conhecidas por serem ambíguas e desafiadoras, mas o Watson demonstrou uma notável capacidade de compreender as perguntas em linguagem natural, buscar informações relevantes em grandes volumes de dados não estruturados e gerar respostas precisas em tempo real. Imagem: Ben Hider/Getty Images

Liderado por uma equipe de pesquisadores do Google, incluindo Andrew Ng e Jeff Dean, em 2012,, o Google Brain desenvolveu um modelo de rede neural profunda chamado “DistBelief” que era capaz de treinar redes neurais de forma escalável em grandes volumes de dados.

Utilizando técnicas de aprendizado profundo, o sistema conseguiu melhorar substancialmente a precisão do reconhecimento de objetos em imagens.

Essa conquista foi um marco importante para a inteligência artificial e o campo de visão computacional.

Ao desenvolver um modelo de rede neural profunda eficiente, o Google Brain abriu caminho para uma série de aplicações práticas, como reconhecimento de imagens em larga escala, identificação de objetos e classificação de conteúdo visual.

Pesquisar por imagens, encontrar relações e conexões, traduzir textos de fotos e muitas outras ferramentas surgiram com essas aplicações. Em algum momento, você provavelmente já deve ter usado alguma delas no seu dia a dia. Imagem: Reprodução/iStock.

A contribuição do Google Brain para o avanço do aprendizado profundo e do reconhecimento de imagens foi fundamental para impulsionar a pesquisa e o desenvolvimento de algoritmos de visão computacional em vários setores, incluindo medicina, automação industrial, veículos autônomos e muito mais.

Go é um jogo de tabuleiro estratégico extremamente complexo, considerado um dos desafios mais difíceis para a inteligência artificial devido ao grande número de possíveis jogadas e à natureza intuitiva do jogo.

Em 2016, a AlphaGo, da DeepMind, utilizando técnicas de aprendizado de máquina, redes neurais e algoritmos de busca, foi capaz de superar a habilidade humana e derrotar Lee Sedol, um dos jogadores mais talentosos do mundo.

Essa vitória foi um marco significativo no campo da inteligência artificial, pois o Go era considerado um jogo inatingível para as máquinas devido à sua complexidade estratégica e à necessidade de intuição humana para jogá-lo com sucesso.

A conquista da AlphaGo demonstrou o poder e o potencial das técnicas de aprendizado de máquina em lidar com desafios complexos e desencadeou um aumento no interesse e no investimento em IA, impulsionando ainda mais a pesquisa e o desenvolvimento de algoritmos avançados para diversas aplicações.

Se você ficou curioso sobre como isso aconteceu, tem um documentário sobre esse jogo e o resultado da Alpha Go disponível no YouTube! Aproveite para assistir e se surpreender.

Em 2017, pudemos observar alguns avanços significativos, com sistemas baseados em redes neurais alcançando níveis de precisão próximos aos da capacidade humana, dentro da comunicação.

Esses avanços foram impulsionados pelo desenvolvimento de modelos de aprendizado profundo, como as redes neurais recorrentes e as redes neurais convolucionais, que permitiram uma melhor compreensão e processamento de sequências de texto.

No reconhecimento de fala, os sistemas baseados em redes neurais foram capazes de interpretar e transcrever com precisão o conteúdo falado em diferentes idiomas.

Isso levou a melhorias significativas em aplicativos de assistentes virtuais, transcrição automática de áudio, legendagem de vídeos e muito mais.

Na tradução automática, os sistemas baseados em redes neurais obtiveram avanços notáveis na qualidade das traduções, aproximando-se cada vez mais da fluidez e da compreensão humana.

Esses sistemas foram capazes de analisar o contexto, capturar nuances linguísticas e gerar traduções mais precisas em tempo real. Imagem: Reprodução/iStock.

Tendo enfim um impacto significativo em várias áreas, incluindo comunicação global, acessibilidade e interação homem-máquina, proporcionando uma experiência mais natural e eficiente na compreensão e produção de linguagem.

No ano de 2021, com certeza houve avanços significativos no campo de modelos de inteligência artificial generativa, com destaque para o GPT-3 (Generative Pre-trained Transformer) e outros modelos semelhantes.

O GPT-3, desenvolvido pela OpenAI, é um modelo de linguagem baseado em redes neurais que alcançou um nível impressionante de capacidade generativa de texto.

Ele foi treinado em uma quantidade massiva de dados de texto e pode gerar conteúdo em uma variedade de estilos e contextos.

Além disso, ele apresentou melhorias notáveis na qualidade e na sofisticação das gerações de texto em comparação com seus predecessores, demonstrando a capacidade de gerar textos coerentes, com uma voz consistente e em resposta a comandos ou perguntas específicas.

Modelo de linguagem altamente avançado baseado em redes neurais, desenvolvido pela OpenAI, que alcançou notável capacidade generativa de texto, apresentando melhorias significativas em relação a seus predecessores. . Imagem: Reprodução/iStock.

Esses modelos podem ser aplicados em diversas áreas, como redação assistida, tradução automática, criação de histórias, chatbots, resumos de texto e muito mais.

Eles têm o potencial de agilizar tarefas de escrita, ajudar na criatividade e fornecer assistência em várias aplicações de linguagem natural.

Tais avanços nos modelos de IA generativa destacam o progresso contínuo na capacidade das máquinas em produzir conteúdo humano-like e abrem possibilidades interessantes para a automação de tarefas criativas e interativas. Isso te assusta?

Depois de entendermos pontualmente cada marco histórico da existência da Inteligência Artificial, é importante entendermos de forma simplificada tais mudanças. Por isso, seguimos com um resumo desta linha do tempo da IA, apresentando:

Inteligência artificial através do tempo. Imagem: Reprodução/ Mídia Market

Nos últimos anos, a inteligência artificial (IA) tem experimentado avanços significativos, impulsionados pelo aumento da capacidade computacional e pelo acesso a grandes volumes de dados.

Como falamos anteriormente, a última e maior mudança observada foi a apenas dois anos, tendo modificações e atualizações nos últimos meses.

A evolução da inteligência artificial reflete não apenas avanços tecnológicos, mas também mudanças nas abordagens teóricas e nas expectativas sociais. Imagem: Reprodução/ iStock

Esses desenvolvimentos têm permitido aplicações cada vez mais sofisticadas em uma variedade de setores, como por exemplo:

GPUs (Unidades de Processamento Gráfico) de alto desempenho têm sido amplamente utilizadas para acelerar o processamento de dados em tarefas intensivas em computação, como treinamento de redes neurais.

O desenvolvimento de chips especializados, como os ASICs (Circuitos Integrados de Aplicação Específica), tem impulsionado o desempenho e a eficiência energética de algoritmos de IA.

A IA continua a evoluir, e os desafios éticos e sociais associados ao seu desenvolvimento também estão se tornando cada vez mais importantes. Imagem: Reprodução/ Mídia Market

A disponibilidade de grandes conjuntos de dados tem sido fundamental para treinar modelos de IA. Empresas e organizações têm coletado e armazenado dados em grande escala, fornecendo uma base robusta para o treinamento de algoritmos de aprendizado de máquina.

O uso de técnicas de processamento distribuído e computação em nuvem permitiu a manipulação eficiente de grandes volumes de dados para aplicações de IA.

As redes neurais profundas, também conhecidas como redes neurais de aprendizado profundo, têm sido uma área de grande avanço na IA.

O aprendizado profundo tem sido aplicado em diversas tarefas, como reconhecimento de imagens, processamento de linguagem natural, tradução automática e até mesmo jogos estratégicos, demonstrando resultados impressionantes.

Esses modelos consistem em várias camadas de neurônios artificiais interconectados, permitindo a extração de características complexas e o processamento de dados não lineares. Imagem: Reprodução/ Mídia Market

Assistente virtuais, chatbots e interfaces de voz têm se tornado cada vez mais presentes em nosso cotidiano.

Com avanços em processamento de linguagem natural e reconhecimento de fala, esses sistemas são capazes de entender e responder a comandos e perguntas dos usuários. Imagem: Reprodução/ iStock

Empresas de tecnologia têm investido fortemente no desenvolvimento de assistentes virtuais, que podem auxiliar em tarefas como agendamento de compromissos, busca de informações, reprodução de músicas, controle de dispositivos domésticos inteligentes, entre outros.

Conta pra gente: você costuma controlar sua agenda com uma assistente?

Com algoritmos de IA, é possível realizar tarefas como reconhecimento de objetos, detecção facial, análise de sentimentos e segmentação de imagens (Andamos felizes com os aplicativos que ajudam a identificar plantas e suas necessidades, por exemplo).

A aplicação da visão computacional tem impactado áreas como medicina (detecção de doenças a partir de exames de imagem), segurança (vigilância por vídeo), indústria (inspeção automatizada de produtos) e veículos autônomos (como Tesla).

Empresas como a Tesla utilizam visão computacional em seus veículos autônomos para identificar obstáculos, pedestres, sinalizações de trânsito e outras informações importantes para a navegação segura. Imagem: Reprodução/ iStock

Algoritmos de IA têm sido empregados em tarefas como reconhecimento de fala, tradução automática, sumarização de texto, chatbots e análise de sentimentos em mídias sociais.

Esses avanços têm impactado setores como atendimento ao cliente, análise de dados textuais, produção de conteúdo automatizado e pesquisa acadêmica. Imagem: Reprodução/ iStock

Enquanto não alcançamos o modelo de Inteligência Artificial Geral e alteramos toda a nossa forma de vida humana, nos atentamos àquilo que está em constante evolução, com várias tendências emergentes que tendem a moldar o futuro dessa tecnologia.

Algumas das coisas que precisamos dar mais atenção nos próximos anos incluem:

Permitindo que os sistemas de IA se tornem mais capazes de aprender com dados em tempo real, adaptar-se a mudanças e melhorar o desempenho ao longo do tempo.

Dessa forma, será possível abrir novas possibilidades em áreas como processamento de linguagem natural, visão computacional, análise de dados e tomada de decisões autônomas.

O aprendizado contínuo representa uma abordagem mais dinâmica e adaptativa em comparação com modelos de aprendizado estáticos. Imagem: Reprodução/ iStock

Já estamos vendo algumas mudanças e necessidades para tornar a IA cada vez mais integrada em nossa sociedade, mas com mais transparência e explicabilidade.

Da mesma forma, tende a ser utilizada de maneira responsável, justa e respeitando os direitos humanos.

É visível que serão desenvolvidas técnicas para tornar os algoritmos de IA mais compreensíveis, explicando como tomam decisões e reduzindo o viés algorítmico. Imagem: Reprodução/ iStock

A IA continuará a automatizar tarefas repetitivas e de rotina, permitindo que os humanos se concentrem em atividades de maior valor agregado, como criatividade, tomada de decisões estratégicas e resolução de problemas complexos.

Além disso, veremos um aumento na colaboração entre humanos e sistemas de IA, com ela fornecendo suporte e assistência para melhorar o desempenho humano em várias áreas.

Esse fenômeno não apenas aumenta a eficiência nas operações diárias, mas também redefine o papel dos profissionais em vários setores. Imagem: Reprodução/ iStock

A IA desempenhará um papel cada vez mais importante na saúde e medicina, com avanços em diagnóstico, descoberta de medicamentos, personalização de tratamentos e monitoramento de pacientes.

Veremos um aumento no uso de algoritmos de IA para analisar grandes conjuntos de dados médicos e genômicos, fornecendo insights valiosos para a prevenção, diagnóstico e tratamento de doenças.

A inteligência artificial está desempenhando um papel cada vez mais importante na área da saúde, oferecendo oportunidades para melhorar o diagnóstico, tratamento, gestão de dados e pesquisa médica. Imagem: Reprodução/ iStock

Da mesma forma, a Inteligência Artificial será fundamental para impulsionar o desenvolvimento de cidades inteligentes, onde os sistemas de IA serão usados para otimizar o gerenciamento de tráfego, a eficiência energética, o fornecimento de serviços públicos e a segurança pública.

Da mesma maneira, também ajudará a melhorar a qualidade de vida dos cidadãos, permitindo serviços personalizados e adaptados às necessidades individuais.

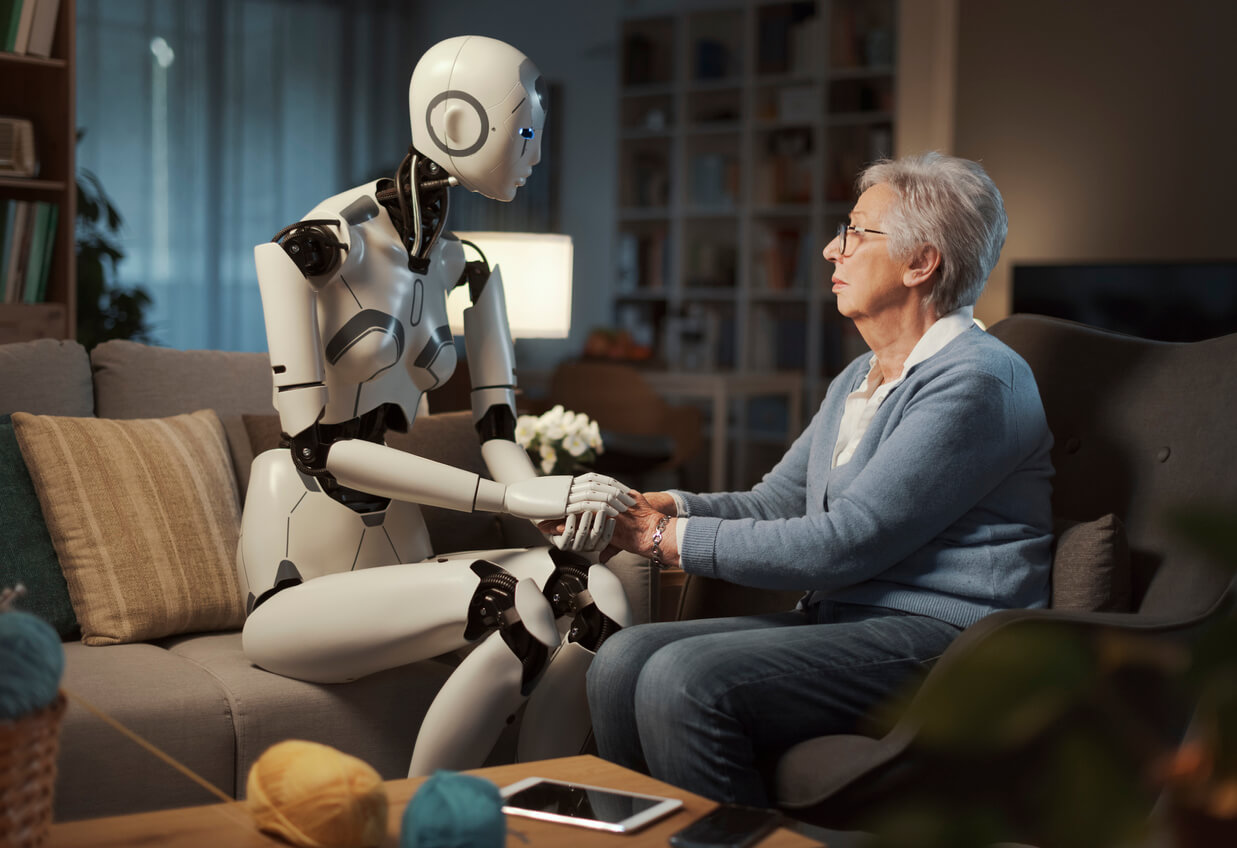

Sem “robôs do mal”, a combinação de IA e robótica abrirá novas possibilidades em vários setores, como manufatura, logística, cuidados de saúde e serviços domésticos.

A sinergia entre IA e robótica abre portas para grandes avanços, catalisando a criação de robôs autônomos capazes de executar com segurança tarefas complexas, impulsionando a inovação em diversos setores. Imagem: Reprodução/iStock.

Veremos um aumento no desenvolvimento de robôs inteligentes e autônomos, capazes de interagir com o ambiente, tomar decisões em tempo real e realizar tarefas complexas com segurança.

Entendemos que a Inteligência Artificial não é algo a ser combatido, mas uma possibilidade e uma oportunidade de economizar tempo, dinheiro e recursos, facilitando as diferentes formas de comunicação e tarefas, aplicadas aos mais diversos setores.

Esta não deve ser uma briga a ser comprada, uma disputa a ser evitada. A IA existe há mais de 60 anos e cada vez mais ela vem se aplicando não só de forma palpável, mas também subjetiva em nossas vidas.

Aprender a lidar com ela é o futuro. Esteja preparado para isso!